封面新闻记者 车家竹

为何进行速率限制?

有助于防止恶意攻击和滥用行为

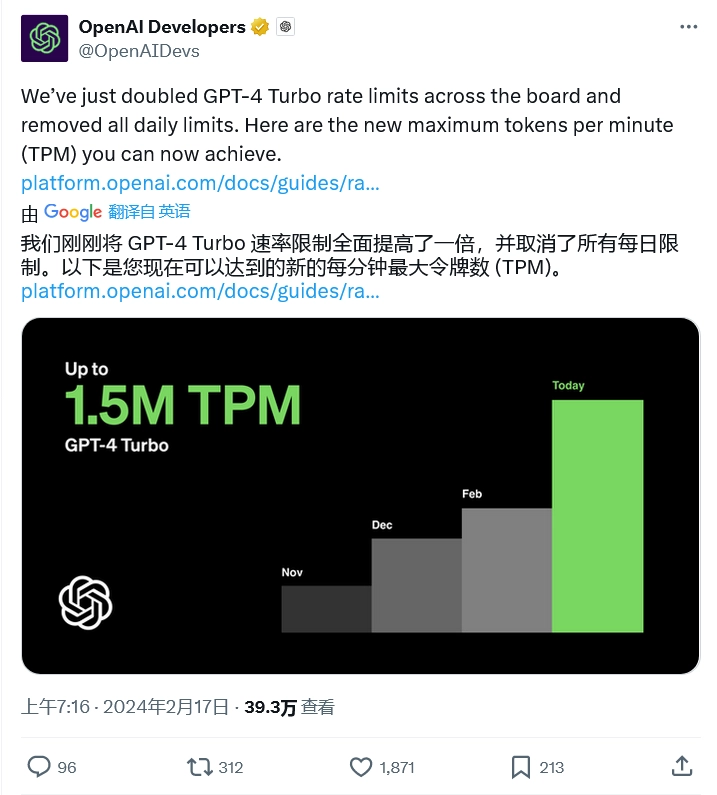

OpenAI表示,速率限制是对开发者或产品用户,在指定时间段内访问OpenAI服务器的次数增加的一种服务限制。

2月21日,中国信息协会常务理事、国研新经济研究院创始院长朱克力在接受封面新闻记者采访时表示,“OpenAI进行速率限制主要是出于三个方面的考虑。一是为了保护其强大的AI模型,防止因过度使用而导致的性能下降或损坏。毕竟,这些模型是OpenAI花费大量时间和资源训练出来的,必须妥善维护,同时OpenAI作为初创公司资源有限,AI大模型消耗资源巨大。二是为了确保所有用户都能获得稳定、可靠的服务。如果没有速率限制,一些用户可能会过度消耗资源,导致其他用户的服务质量下降。三是速率限制也有助于防止恶意攻击和滥用行为,从而维护整个系统的安全性和稳定性。”

速率限制有哪些种类?

最常见的是基于时间的限制

速率限制则是OpenAI对开发者或产品用户,在指定时间段内访问其服务器的次数增加的一种服务限制。目前,OpenAI一共使用了5种速率限制:RPM(每分钟请求数)、RPD(每天请求数)、TPM(每分钟tokens数量)、TPD(每天tokens数量)和IPM(每分钟图像数量);其中任何一种请求都可能触发速率限制。

“OpenAI的速率限制有多种类型。最常见的是基于时间的限制,比如每分钟、每小时或每天可以发送的请求次数。这种限制可以确保用户在一定时间内不会过度使用服务。此外,还有基于数据量的限制,比如每次请求可以处理的数据量或每天可以处理的总数据量。这种限制可以防止用户发送过大的请求,从而保护系统的处理能力。”朱克力解释道。

资料图

如何避免速率限制?

用户需合理规划请求的频率和数量

OpenAI表示,最简单的避免速率限制方法,就是使用“指数退避重试”。指数退避重试能在连续的失败尝试之间引入逐渐增加的延迟,以减少对服务器或网络资源的压力,增加后续尝试成功的可能性。

对此,朱克力向记者表示:“要避免速率限制,用户可以采取一些策略。首先,要合理规划请求的频率和数量,避免在短时间内发送大量请求。其次,可尝试分批处理数据,将大请求拆分成多个小请求,以减少单次请求的负担。同时,用户还可以考虑使用缓存技术,将已经处理过的数据保存起来,避免重复请求相同的数据。此外,与OpenAI保持良好的沟通也很重要,如果用户确有特殊需求需突破速率限制,可以向OpenAI申请提升限制或购买更高级别的服务。”但需要注意的是,速率限制是对组织级别实施的,对一般个体用户并无影响,且速率限制因所使用的模式而异,用户可以在账户设置中的 “限制”板块查看速率和使用限制。

最后,朱克力还补充道:“OpenAI的速率限制是为了保护其宝贵的AI资源和确保所有用户都能获得高质量的服务,用户在理解和尊重这些限制的同时应采取有效措施避免触发,共同维护一个稳定、安全、高效的AI生态环境。”

评论 4

一二八字 2024-02-28 发表于四川

不懂

心怀不诡 2024-02-23 发表于四川

科技发展日新月异

剑阁县公安局驻杨村镇柏梓村第一 2024-02-22 发表于辽宁

好